Search Engine là gì? Top các công cụ tìm kiếm hiệu quả nhất

Search Engine là cánh cổng quyền lực giúp hàng tỷ người dùng sắp xếp kho thông tin khổng lồ trên Internet. Để website của bạn nổi bật, Tinymedia.vn cung cấp giải pháp toàn diện giúp bạn thấu hiểu và chinh phục các cỗ máy tìm kiếm, từ cơ chế hoạt động, thuật toán xếp hạng đến xu hướng trí tuệ nhân tạo mới nhất.

Dịch vụ Seo AI Tối ưu Chuyển Đổi

Chúng tôi không chỉ cam kết đưa bạn lên TOP Google mà còn tập trung cải thiện trực tiếp hiệu suất bán hàng. Với kỹ thuật tối ưu CSS và HTML độc quyền, website của bạn sẽ tăng tốc độ tải trang 30%, đẩy tỷ lệ chuyển đổi lên đến 25% chỉ trong 8 tuần. Tích hợp sản phẩm trực tiếp vào bài blog giúp khách hàng mua sắm liền mạch, giảm 40% tỷ lệ thoát trang.

Search Engine hoạt động theo cơ chế nào và có lịch sử phát triển ra sao?

Search Engine, hay công cụ tìm kiếm, là một hệ thống phần mềm phức tạp hoạt động dựa trên ba bước chính: Thu thập dữ liệu (Crawling) bằng các robot tự động, Lập chỉ mục (Indexing) để sắp xếp thông tin vào một cơ sở dữ liệu khổng lồ, và Xếp hạng (Ranking) kết quả dựa trên hàng trăm yếu tố để trả về câu trả lời phù hợp nhất cho người dùng.

Quá trình này là nền tảng của mọi trình tìm kiếm hiện đại, từ Google đến Bing, đảm bảo rằng khi bạn nhập một truy vấn, bạn sẽ nhận được kết quả liên quan chỉ trong vài mili giây. Hãy cùng phân tích sâu hơn về từng giai đoạn cốt lõi này.

Bước 1: Thu thập dữ liệu (Crawling) – Khám phá Internet

Crawling là quá trình các chương trình máy tính tự động, thường được gọi là bots, spiders, hay crawlers, liên tục quét qua Internet để tìm kiếm các trang web mới hoặc được cập nhật. Chúng hoạt động không ngừng nghỉ, 24/7, đi theo các siêu liên kết từ trang này sang trang khác, giống như một người dùng đang lướt web, để khám phá nội dung.

- ✔ Điểm khởi đầu: Quá trình thường bắt đầu từ một danh sách các địa chỉ web đã biết, được thu thập từ các lần thu thập dữ liệu trước đó và sitemap do chủ sở hữu trang web cung cấp.

- ✔ Cơ chế hoạt động: Khi một bot truy cập một trang web, nó sẽ đọc nội dung của trang và xác định tất cả các liên kết trên đó. Những liên kết này sau đó được thêm vào danh sách các trang cần thu thập dữ liệu tiếp theo. Quá trình này tạo ra một mạng lưới liên kết khổng lồ, cho phép các cỗ máy tìm kiếm lập bản đồ World Wide Web.

- ✔ Vai trò của Robots.txt: Các chủ website có thể kiểm soát cách bots tương tác với trang của mình thông qua một tệp tin đặc biệt là robots.txt. Tệp này cung cấp chỉ dẫn cho bots, cho biết chúng được phép hoặc không được phép truy cập vào những phần nào của trang web.

Vào năm 2025, quy mô của hoạt động này đã đạt đến một tầm mức không tưởng. Tổng số lượt truy vấn tìm kiếm trên toàn cầu, bao gồm cả các nền tảng AI như ChatGPT và Google AI Overview, đã vượt mốc 16 tỷ lượt mỗi ngày. Điều này cho thấy vai trò không thể thiếu của các hệ thống tìm kiếm trong việc điều hướng đại dương thông tin kỹ thuật số.

Bước 2: Lập chỉ mục (Indexing) – Tổ chức thư viện số

Indexing là quá trình lưu trữ và sắp xếp thông tin đã được thu thập trong giai đoạn crawling vào một cơ sở dữ liệu khổng lồ được gọi là chỉ mục (index). Nếu crawling là việc thu thập sách cho một thư viện, thì indexing chính là việc phân loại và xếp chúng lên kệ một cách khoa học để có thể tìm thấy ngay lập tức.

Trong bước này, công cụ tìm kiếm sẽ phân tích nội dung của từng trang, bao gồm văn bản, hình ảnh, video, thẻ tiêu đề, mô tả và các dữ liệu có cấu trúc khác. Nó xác định các từ khóa chính, chủ đề của trang và lưu trữ thông tin này một cách có hệ thống. Thuật toán PageRank, mặc dù đã được cải tiến và bổ sung bởi nhiều yếu tố khác, vẫn là một khái niệm nền tảng trong việc đánh giá và sắp xếp thông tin này một cách logic, dựa trên uy tín của các liên kết.

Bước 3: Xếp hạng (Ranking) – Trả về kết quả tốt nhất

Ranking là bước cuối cùng và quan trọng nhất, quyết định thứ tự xuất hiện của các trang web trên trang kết quả tìm kiếm (SERP) khi người dùng thực hiện một truy vấn. Đây là nơi các thuật toán phức tạp nhất của bộ máy tìm kiếm phát huy tác dụng.

Google sử dụng hàng trăm tín hiệu xếp hạng để xác định trang web nào là câu trả lời tốt nhất. Các tín hiệu này bao gồm:

- ✔ Sự liên quan và chất lượng nội dung: Nội dung có trả lời đúng ý định tìm kiếm của người dùng không? Nó có chuyên sâu, chính xác và đáng tin cậy không?

- ✔ Uy tín của website (Authority): Website có được nhiều trang web uy tín khác trỏ backlink đến không? Đây là một yếu tố thể hiện thẩm quyền chủ đề.

- ✔ Trải nghiệm người dùng (UX): Việc trải nghiệm người dùng trên trang có tốt không? Trang có dễ điều hướng, giao diện có thân thiện không?

- ✔ Các yếu tố kỹ thuật: Tốc độ tải trang có nhanh không? Trang có thân thiện với thiết bị di động không? Cấu trúc website có logic không?

Gần đây, với sự ra đời của AI Overview (trước đây là SGE), khả năng cung cấp câu trả lời trực tiếp, súc tích và tổng hợp thông tin từ nhiều nguồn cũng trở thành một yếu tố quan trọng, định hình lại tương lai của tìm kiếm.

Lịch sử phát triển của Search Engine đã diễn ra như thế nào?

Hành trình của Search Engine bắt đầu từ những công cụ thô sơ như Archie (1990) chỉ lập chỉ mục tệp, tiến đến các thư mục web thủ công như Yahoo! (1994), rồi bùng nổ với các công cụ tìm kiếm toàn văn bản như AltaVista (1995). Cuối cùng, Google (1998) đã cách mạng hóa ngành công nghiệp với thuật toán PageRank, và ngày nay, cuộc chơi đang được định hình lại bởi trí tuệ nhân tạo và tìm kiếm ngữ nghĩa.

1. Giai đoạn sơ khai (Trước 1993): Tìm kiếm trong bóng tối

Trước khi World Wide Web phổ biến, việc tìm kiếm thông tin trên mạng là một thử thách thực sự. Các hệ thống chủ yếu dựa trên việc lập chỉ mục tệp tin thay vì nội dung trang web, đòi hỏi người dùng phải có kiến thức kỹ thuật nhất định.

- Archie (1990): Được xem là công cụ tìm kiếm đầu tiên, Archie được tạo bởi Alan Emtage. Nó không lập chỉ mục nội dung mà chỉ tạo ra một danh sách các tệp tin có thể tải xuống từ các máy chủ FTP công cộng. Người dùng cần biết chính xác tên tệp để tìm kiếm, khiến nó rất hạn chế.

- Veronica và Jughead (1991): Hai công cụ này phục vụ Gopher, một hệ thống menu điều hướng phổ biến trước web. Veronica tìm kiếm tiêu đề menu, trong khi Jughead tìm kiếm trong các thư mục của một máy chủ Gopher cụ thể.

- WAIS (Wide Area Information Servers): WAIS là một bước tiến khi cho phép tìm kiếm toàn văn bản trong các cơ sở dữ liệu. Tuy nhiên, điểm yếu của nó là người dùng phải biết chính xác cơ sở dữ liệu nào chứa thông tin họ cần.

2. Thời kỳ đầu của Web (1993-1996): Những người tiên phong

Sự ra đời của World Wide Web năm 1991 bởi Tim Berners-Lee đã mở ra một kỷ nguyên mới, kéo theo nhu cầu cấp thiết về các công cụ tìm kiếm hiệu quả hơn để điều hướng biển thông tin đang lớn dần.

- Wandex (1993): Được tạo bởi Matthew Gray tại MIT, Wandex là robot web (web crawler) đầu tiên và được ghi nhận là chỉ mục web đầu tiên trong lịch sử, dù quy mô còn rất nhỏ.

- JumpStation (1993): Công cụ này là một bước tiến lớn khi kết hợp cả ba chức năng cốt lõi của một công cụ tìm kiếm hiện đại: crawling, indexing, và searching. Nó lập chỉ mục tiêu đề và các đề mục của trang web để người dùng có thể tìm kiếm.

- Aliweb (1993): Aliweb không sử dụng bot. Thay vào đó, nó cho phép các quản trị viên web tự gửi mô tả về trang của họ. Cách tiếp cận này nhanh hơn nhưng lại phụ thuộc hoàn toàn vào sự chủ động của người tạo web.

3. Các Search Engine hiện đại (1996-2000): Cuộc chiến của những gã khổng lồ

Giai đoạn này chứng kiến sự cạnh tranh khốc liệt và sự trỗi dậy của nhiều tên tuổi lớn, định hình nên thị trường tìm kiếm trực tuyến. Các công cụ này cho phép tìm kiếm toàn văn bản, giúp người dùng có thể tìm kiếm theo cụm từ thay vì chỉ từ khóa đơn lẻ.

- Lycos (1994), Excite (1995), AltaVista (1995): Đây là những gã khổng lồ thực sự của thời kỳ này. AltaVista đặc biệt nổi bật với khả năng lập chỉ mục một lượng lớn trang web và cung cấp kết quả tìm kiếm gần như tức thì.

- Yahoo! Search (1994): Xuất phát điểm là một thư mục web được sắp xếp thủ công bởi hai nhà sáng lập Jerry Yang và David Filo, Yahoo! nhanh chóng trở thành cổng thông tin số một trên Internet. Sau đó, họ tích hợp công cụ tìm kiếm và thống trị thị trường trong nhiều năm.

4. Sự thống trị của Google và kỷ nguyên AI (2000-nay)

Sự xuất hiện của Google đã thay đổi cuộc chơi mãi mãi, và giờ đây, trí tuệ nhân tạo đang tiếp tục định hình lại tương lai của tìm kiếm, biến nó trở thành một cỗ máy trả lời thông minh.

- Google (1998): Được thành lập bởi Larry Page và Sergey Brin, Google mang đến một cuộc cách mạng với thuật toán PageRank. Thay vì chỉ phân tích nội dung trên trang, PageRank đánh giá tầm quan trọng của một trang web dựa trên số lượng và chất lượng của các liên kết trỏ đến nó. Cách tiếp cận này đã cung cấp các kết quả tìm kiếm liên quan và đáng tin cậy hơn nhiều, giúp Google nhanh chóng vượt qua mọi đối thủ.

- Sự phát triển của tìm kiếm ngữ nghĩa và AI (2010-nay): Google không ngừng cải tiến. Các thuật toán như Hummingbird, RankBrain, BERT và gần đây nhất là MUM đã giúp Google hiểu được ý định và ngữ cảnh đằng sau truy vấn của người dùng. Ngày nay, AI Overview đang chuyển mình thành một cỗ máy trả lời, tổng hợp thông tin để đưa ra câu trả lời trực tiếp ngay trên SERP, tạo ra các tìm kiếm không nhấp chuột.

Dịch vụ viết bài Seo & Chuyển Đổi

Nội dung chất lượng là linh hồn của SEO. Chúng tôi không chỉ giúp bạn Rank Top bền vững mà còn tích hợp sản phẩm trực tiếp vào bài blog bằng CSS/HTML độc quyền. Với hơn 5 năm kinh nghiệm, Tinymedia cam kết nội dung bạn nhận được sẽ thu hút traffic chất lượng, xây dựng thẩm quyền chủ đề và tạo ra chuyển đổi cao, giúp bạn tiết kiệm thời gian và chi phí hiệu quả.

So sánh các Search Engine phổ biến nhất hiện nay

Google vẫn là bá chủ toàn cầu với gần 90% thị phần, tập trung vào trải nghiệm người dùng và nội dung chất lượng cao. Bing, với khoảng 4%, là đối thủ lớn thứ hai và là cửa ngõ cho các chatbot AI như Copilot. DuckDuckGo thu hút người dùng quan tâm đến quyền riêng tư, trong khi Yandex và Baidu lần lượt thống trị thị trường Nga và Trung Quốc với các thuật toán riêng biệt.

Dưới đây là bảng so sánh chi tiết các công cụ tìm kiếm phổ biến, được cập nhật mới nhất vào Quý 3 năm 2025.

| Search Engine | Năm sáng lập | Thị phần toàn cầu (ước tính T7/2025) | Nhà sáng lập | Phổ biến ở | Nhận xét về SEO |

|---|---|---|---|---|---|

| 1998 | ~89.5% | Larry Page & Sergey Brin | Toàn cầu | Cạnh tranh cực cao, thuật toán phức tạp (E-E-A-T, Core Web Vitals). SEO cần chiến lược toàn diện, đặc biệt là tối ưu cho AI Overview và tìm kiếm bằng giọng nói. | |

| Bing | 2009 | ~4.0% | Microsoft | Mỹ, Châu Âu | Cạnh tranh thấp hơn. SEO ưu tiên tối ưu hình ảnh, video và mạng xã hội. Là cổng chính cho AI của Microsoft (Copilot), nên tối ưu cho tìm kiếm đàm thoại là rất quan trọng. |

| Yahoo! | 1994 | ~1.1% | Jerry Yang & David Filo | Mỹ, Nhật Bản | Kết quả tìm kiếm được cung cấp bởi Bing, do đó chiến lược SEO tương tự Bing. Tập trung vào người dùng trung thành và các mảng tin tức, tài chính. |

| Yandex | 1997 | ~2.2% (chủ yếu ở Nga) | Arkady Volozh & Ilya Segalovich | Nga, CIS | Thống trị ở Nga (~64% thị phần). Thuật toán riêng biệt, chú trọng hành vi người dùng trên trang và yếu tố địa lý. Cần tối ưu hóa cho ngôn ngữ và văn hóa Nga. |

| Baidu | 2000 | ~0.8% (toàn cầu) | Robin Li & Eric Xu | Trung Quốc | Thống trị ở Trung Quốc (~52% thị phần). Hệ thống kiểm duyệt nghiêm ngặt, ưu tiên website có hosting tại Trung Quốc. SEO đòi hỏi tuân thủ luật pháp và văn hóa địa phương. |

| DuckDuckGo | 2008 | ~0.5% | Gabriel Weinberg | Toàn cầu (người dùng quan tâm bảo mật) | Lấy kết quả từ nhiều nguồn (bao gồm Bing) và không theo dõi người dùng. SEO tập trung vào nội dung chất lượng, từ khóa chính xác vì không có kết quả cá nhân hóa. |

Để thành công, chiến lược SEO của bạn cần phải đa dạng. Trong khi Google là chiến trường chính, việc tối ưu cho Bing cũng đồng nghĩa với việc bạn đang tiếp cận người dùng của Yahoo!, DuckDuckGo và Ecosia. Nếu mục tiêu kinh doanh của bạn hướng đến các thị trường đặc thù như Nga hay Trung Quốc, việc xây dựng một chiến lược SEO riêng cho Yandex và Baidu là bắt buộc.

Tại sao học về Search Engine và SEO lại quan trọng để gia tăng thu nhập?

Hiểu rõ Search Engine và SEO là kỹ năng mang lại lợi thế cạnh tranh tuyệt đối trong kỷ nguyên số. Nó giúp bạn thu hút khách hàng tiềm năng đến với website một cách tự nhiên, xây dựng thương hiệu bền vững và tối đa hóa doanh thu mà không phụ thuộc hoàn toàn vào quảng cáo trả phí. Đây là một khoản đầu tư kiến thức mang lại lợi nhuận lâu dài và bền vững.

Trong một thế giới mà 93% trải nghiệm trực tuyến bắt đầu bằng một công cụ tìm kiếm, việc bỏ qua SEO đồng nghĩa với việc bạn đang tự làm mình trở nên vô hình trước hàng triệu khách hàng tiềm năng. Việc nắm vững cách các Thuật toán SEO hoạt động trên một Website thân thiện với SEO và cách tổ chức nội dung qua Keyword Clustering không còn là một lựa chọn, mà là một yêu cầu bắt buộc để tồn tại và phát triển.

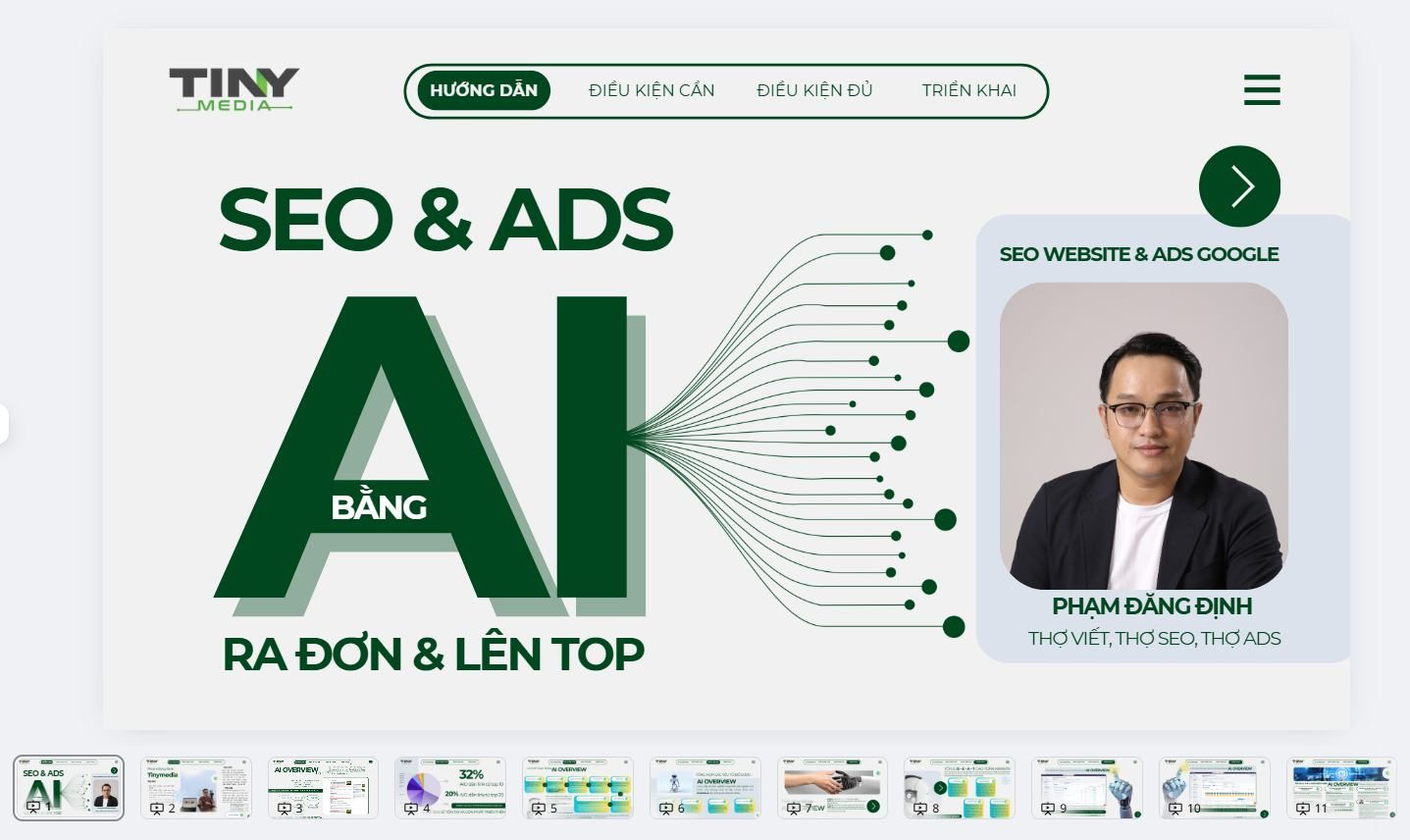

Khóa học Seo website Ai & Ads Google Chuyển Đổi

Khóa học này sẽ giúp bạn dùng AI sản xuất hàng loạt content bán hàng, kết hợp Google Ads (DSA) để lọc ra nhóm từ khóa mua hàng có tỷ lệ chuyển đổi 8-10%. Chiến lược kết hợp 300+ Social Entity giúp website thống trị Google, biến traffic thành đơn hàng thực tế. Đăng ký ngay để biến website thành cỗ máy in tiền tự động.

Làm thế nào để tối ưu SEO trên các Search Engine một cách đơn giản?

SEO (Search Engine Optimization) là quá trình cải thiện website để tăng thứ hạng trên các công cụ tìm kiếm. Quá trình này xoay quanh ba trụ cột chính: On-page SEO (tối ưu nội dung và yếu tố trên trang), Off-page SEO (xây dựng uy tín từ các website khác), và Technical SEO (đảm bảo website có nền tảng kỹ thuật vững chắc).

1. On-page SEO: Tối ưu những gì bạn kiểm soát

On-page SEO bao gồm tất cả các hoạt động tối ưu hóa diễn ra trực tiếp trên website của bạn. Đây là nền tảng để công cụ tìm kiếm hiểu được nội dung của bạn nói về điều gì. Các hoạt động chính trong SEO onpage bao gồm:

- Nghiên cứu từ khóa: Sử dụng các công cụ để thực hiện nghiên cứu từ khóa, tìm ra những gì người dùng đang tìm kiếm và tích hợp chúng một cách tự nhiên vào nội dung. Điều quan trọng là phải hiểu ý định đằng sau từ khóa, từ đó có thể xây dựng Topic cluster và áp dụng Semantic SEO để bao phủ toàn bộ chủ đề.

- Sáng tạo nội dung chất lượng: Viết nội dung chuyên sâu, độc đáo, cung cấp giá trị thực sự cho người đọc và trả lời toàn diện câu hỏi của họ. Ưu tiên các từ khóa dài như Long-Tail Keyword để nhắm đến các truy vấn cụ thể.

- Tối ưu các thẻ HTML: Tối ưu hóa thẻ tiêu đề (Title), mô tả meta (Meta Description), các thẻ heading (H1, H2, H3), và thuộc tính alt cho hình ảnh.

2. Off-page SEO: Xây dựng uy tín và thẩm quyền

Off-page SEO bao gồm các hoạt động diễn ra bên ngoài website của bạn để xây dựng uy tín và thẩm quyền trong mắt công cụ tìm kiếm. Hoạt động quan trọng nhất trong SEO offpage là xây dựng liên kết ngược (backlink) chất lượng từ các trang web uy tín khác. Mỗi backlink được xem như một phiếu bầu, cho thấy nội dung của bạn đáng tin cậy. Ngoài ra, các tín hiệu từ mạng xã hội và việc được đề cập bởi các thương hiệu khác cũng góp phần vào Off-page SEO.

3. Technical SEO: Nền tảng kỹ thuật vững chắc

Technical SEO đảm bảo các yếu tố kỹ thuật của website được tối ưu để các công cụ tìm kiếm có thể thu thập và lập chỉ mục một cách hiệu quả. Các yếu tố quan trọng bao gồm tốc độ tải trang, tính thân thiện với thiết bị di động, cấu trúc website logic, sử dụng sitemap, tệp robots.txt, và dữ liệu có cấu trúc (Schema Markup) để giúp máy tìm kiếm hiểu rõ hơn về nội dung của bạn.

Làm thế nào để khắc phục các sự cố thường gặp khi làm SEO?

Để khắc phục sự cố SEO, hãy bắt đầu bằng việc sử dụng Google Search Console. Công cụ này giúp bạn xác định các vấn đề như trang không được lập chỉ mục do lỗi kỹ thuật hoặc bị chặn bởi robots.txt, phát hiện các liên kết xấu, và nhận cảnh báo nếu website của bạn bị Google phạt. Từ đó, bạn có thể phân tích và đưa ra giải pháp phù hợp.

- Website không được lập chỉ mục: Nguyên nhân có thể do bạn vô tình chặn bot tìm kiếm trong file robots.txt, thẻ noindex, hoặc website có lỗi kỹ thuật nghiêm trọng. Hãy sử dụng Google Search Console để kiểm tra báo cáo Coverage (Phạm vi lập chỉ mục) và gửi lại sitemap để yêu cầu Google thu thập dữ liệu.

- Thứ hạng tìm kiếm thấp hoặc tụt hạng: Điều này có thể do nội dung chưa đủ chất lượng, thiếu backlink uy tín, trải nghiệm người dùng kém, hoặc bị ảnh hưởng bởi một bản cập nhật thuật toán. Cần thực hiện một cuộc audit website toàn diện để xác định điểm yếu và cải thiện.

- Bị phạt bởi Google: Nếu bạn vi phạm các nguyên tắc của Google (ví dụ: sử dụng kỹ thuật SEO mũ đen), website của bạn có thể nhận một tác vụ thủ công. Việc cách kiểm tra website bị Google Phạt rất quan trọng, bạn hãy kiểm tra phần Tác vụ thủ công trong Google Search Console, khắc phục các vi phạm và gửi yêu cầu xem xét lại.

Trong thời đại kỹ thuật số, hiểu rõ Search Engine là gì không chỉ là kiến thức cơ bản mà còn là chìa khóa mở ra thành công. Tinymedia.vn cam kết đồng hành cùng bạn trên hành trình chinh phục đỉnh cao SEO. Hãy bắt đầu ngay hôm nay để không bỏ lỡ cơ hội thăng tiến trong lĩnh vực đầy tiềm năng này.

Ebook Kế Hoạch Content Fanpage

Đừng chỉ tập trung vào Google. Ebook này sở hữu bí kíp dùng 6 ngày triển khai nội dung cho 6 tháng trên Fanpage. Ebook giúp bạn nắm vững quy trình xây dựng Persona, công thức viết bài Viral và cách ứng dụng AI để tự động hóa sản xuất nội dung, tăng tỷ lệ chuyển đổi gấp 6 lần và tạo tín hiệu xã hội tích cực cho SEO.

Phạm Đăng Định là một chuyên gia Digital Marketing, nhà sáng lập và CEO của Tinymedia. Ông được biết đến là người tiên phong đưa ra khái niệm và dịch vụ SEO Chuyển Đổi tại Việt Nam, tập trung vào việc tối ưu chi phí và mang lại hiệu quả kinh doanh thực chất cho các doanh nghiệp.

Hành trình sự nghiệp và dấu ấn chuyên môn

Bắt đầu sự nghiệp từ năm 2012 với chuyên môn về content marketing, ông Phạm Đăng Định đã tích lũy gần 8 năm kinh nghiệm về nội dung và hơn 4 năm chuyên sâu về SEO trước khi thành lập Tinymedia vào đầu năm 2021. Hành trình của ông được định hình bởi triết lý “Lấy nhỏ thắng lớn”, tập trung vào việc mang lại hiệu quả tối đa trên từng chi phí, đặc biệt là cho các doanh nghiệp vừa và nhỏ (SMEs).

💡 Tiên phong với khái niệm SEO Chuyển Đổi 💡

Ông là người đầu tiên giới thiệu dịch vụ SEO Chuyển Đổi, một phương pháp đột phá giúp doanh nghiệp tiết kiệm từ 40-70% chi phí marketing mà vẫn đảm bảo tăng trưởng doanh thu. Cách tiếp cận này nhấn mạnh vào việc tối ưu hóa tỷ lệ chuyển đổi, thay vì chỉ tập trung vào thứ hạng từ khóa, qua đó mang lại giá trị kinh doanh bền vững.

Với vai trò là một freelancer, thơ viết Phạm Đăng Định đã chia sẻ kiến thức chuyên môn cho hơn 2000 học viên và tham gia các sự kiện lớn trong ngành như SEO Performance 2022. Ông còn là cố vấn chuyên môn, cập nhật kiến thức thực chiến về SEO và Ads cho giảng viên tại nhiều cơ sở đào tạo uy tín như FPT Skillking, FPT Polytechnic, và HUTECH, góp phần tích cực vào việc xây dựng một cộng đồng Digital Marketing vững mạnh tại Việt Nam.